每次說什么配置,好像很多人都不明白AR眼鏡里的各種“高大上”配件,還有就是把很多概念混為一談,但是作為一個合格的AR人,我們是不是要把這些基本概念理清楚了再去和客戶爸爸說呢?

手機AR是AR嗎?

實際上我們玩過不少“手機AR”的游戲或者應用,比如說得最多的支付寶掃五福,包括也有不少基于微信小程序所開發的AR應用,但嚴格來說,這些都是「偽AR」。

AR,Augmented Reality增強現實,是對現實世界的信息增強,那么最重要的一點就是要將虛擬信息疊加在現實中,起到對現實世界的信息增強的作用。在這個過程中最重要的就是「識別+疊加」的能力,但手機并不是真正的「識別現實世界并疊加在現實世界」。

確實我們在網上看到過不少類似于基于蘋果ARKit所設計出來的AR應用,但和眼鏡所代表的真正的AR區別究竟在哪里呢?

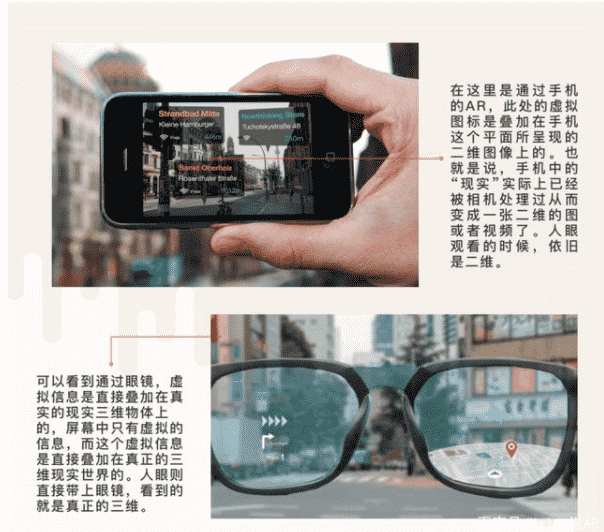

我們在通過手機看到AR的時候,看到的是手機屏幕中的二維圖像或視頻,然后虛擬的信息疊加在這個二維圖像或視頻上;但通過眼鏡來看AR的話,我們所看到的AR則是虛擬信息疊加在真真切切的三維真實物體上的。

換句話說,也就是當我們通過手機去看AR時,已經經過一次手機鏡頭了,從視覺上來說,僅僅只是虛擬疊加在屏幕中的二維圖像或視頻中;但通過眼鏡,我們看到的是實實在在的「虛擬」疊加在「現實」上,這才符合AR的定義。

全景真的是VR嗎?

VR,Virtual Reality虛擬現實,顧名思義提供的是虛擬的環境,并且眾所周知,VR的一大特點是要求沉浸感,此外,3D及6DoF是最基本的要求。但全景VR真的是VR嗎?

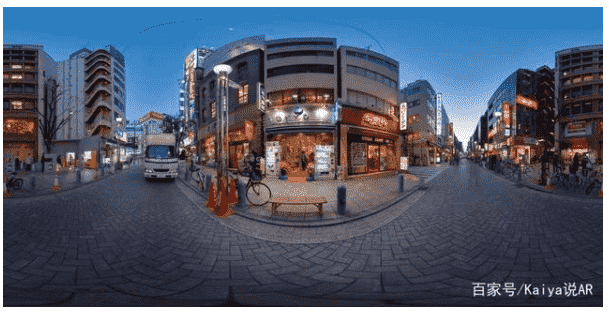

從剛才所提到最重要的三個特征來說,全景視頻應該是一個都不占。以目前比較常見的全景視頻——鏈家VR看房來說,我們確實能夠通過手機上的VR全景視頻看到房子的各個細節,但僅限于在手機或者電腦中觀看,這就還是上面提到的:我們依舊只是在看“假的3D視頻”,因為它僅僅是在二維手機屏幕呈現,因此,它既不是真正的3D,也不具有沉浸感;其次,用戶在觀看全景視頻時,無法在“虛擬的”房子中走動,只能通過點擊點位來切換視角,也就是無法實現6DoF。所以,全景VR不是真正意義上的VR。

下面是一個關于全景和VR的對比

三維重建和SLAM是一個東西嗎?

SLAM這個概念其實已經解釋過挺多次了,但可能還是有人不知道是什么,畢竟上次就被問過什么是SLAM……

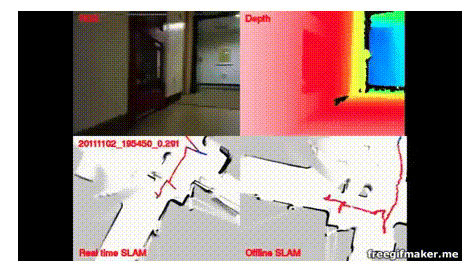

SLAM(simultaneous localization and mapping)實時定位與地圖構建,這個概念最早是在機器人領域運用的比較多,后來逐漸應用到AR、無人駕駛領域。

對于這個概念,機器人領域有一個非常通俗易懂的描述:我們將一個機器人放到它所未知的環境中,通過一邊移動一邊描繪出該環境所對應的地圖。那么實際上在整個機器人移動的過程中,「定位」也就是自己處于該環境的什么位置,是最重要的。

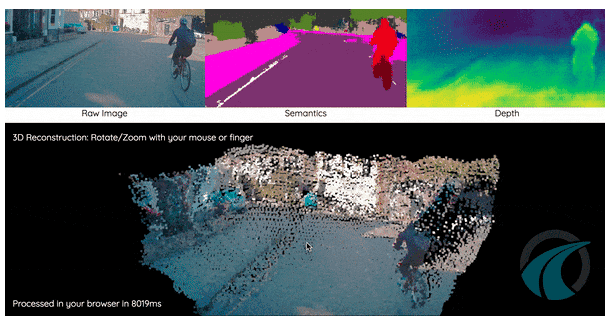

三維重建(3D Reconstruction)是指對三維物體建立適合計算機表示和處理的數學模型,是在計算機環境下對其進行處理、操作和分析其性質的基礎,也是在計算機中建立表達客觀世界的虛擬現實的關鍵技術。可以看到,三維重建是盡可能高精度的還原實體,因此在這個過程中對環境的「精確」建模才是最重要的。

從上述的分析中,基本上就能明白SLAM和三維重建各自的側重點,其實是不一樣的。就目前的技術來說,無法同時做到SLAM和三維重建。因此,暫時可以說SLAM和三維重建不是一個東西。

ToF和LIDAR是一個東西嗎?

首先我們要搞清楚ToF的概念,以及它在AR眼鏡中究竟是起到了什么作用。

ToF(Time of Flight)譯為飛行時間,譬如很多“飛行時間傳感器”,就是ToF。那么這個東西是怎么工作的呢?

ToF相機通過紅外發射器發射調制過的光脈沖(不一定是紅外線),遇到物體反射后,用接收器接收反射回來的光脈沖,然后計算從發射到反射回攝像頭的時間差或相位差,并將數據收集起來,形成一組距離深度數據,從而得到一個立體的3D模型的成像技術。在這個過程中,對于時間的測量要有非常高的精度要求。

而這個ToF,就是實現上述所說的三維重建的一部分關鍵要素。通過ToF,能夠使AR眼鏡感知周圍環境,加上IMU和魚眼攝像頭追蹤,就能夠完整的實現更完美的SLAM。這也就是為什么我們看到目前性價比還不錯的幾款MR眼鏡,基本都是這個配置。

LIDAR是由于今年iPad Pro推出時,被大眾所注意到的一個概念。LIDAR(Light Detection and Ranging)即光探測和測距,激光雷達。

在蘋果官方說明中,蘋果解釋了LiDAR的工作原理:通過測量光觸及物體并反射回來所需的時間,從而確定距離。

是不是覺得和ToF就是一回事?

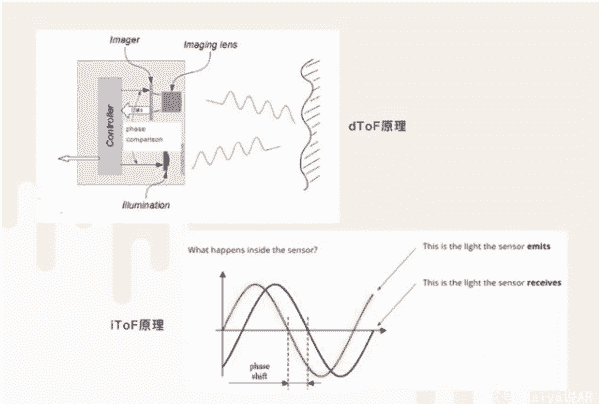

是的,LiDAR就是ToF的一種。但LiDAR屬于ToF中的dToF(直接飛行傳感器),而相對應的,還有另一種叫做iToF(間接飛行傳感器)。dToF發出的是激光束,而iToF發出的是經過正弦波調制,明暗強度呈規律變換的光信號。但iToF的傳感器反應速度沒有dToF那么快,無法做到精確感知皮秒、納秒級別的時間差。因此iToF 靠感知正弦波光信號的差異來「估算」其從發射到反射回來的距離。而dToF是激光直接測算距離。所以相比dToF,iToF只能在比較小的范圍內測距。

目前智能手機大多是iToF,AR眼鏡上多是dToF。

RGB攝像頭?魚眼攝像頭?ToF攝像頭?

RGB攝像頭:每一個顏色都能用RGB(紅,綠,藍)三個變量來表示。攝像頭通常是用三個獨立的CCD傳感器來獲取三種彩色信號。顧名思義在AR眼鏡中,RGB攝像頭是用來做顏色采集的。

魚眼攝像頭:人眼集中注意力時所能看到的最大角度只有25度,但魚眼攝像頭能夠接近180度,在常見的MR眼鏡中,一般都是配備雙魚眼攝像頭,配合IMU,能夠進行6DoF追蹤。而Hololens2則配備了4個。

來源: Kaiya說AR