此前我們報道大量蘋果、微軟等相關專利,從中我們或多或少了解一些產品信息,但關于AR眼鏡(消費級)的未來仍然沒有一個明確答案,而這個過程,可能會比VR(2014年Oculus首個VR產品走向大眾,到2020年VR有大眾化的普及趨勢)更久。

今天,我們就從其中一點來看,那就是AR中的人臉識別,本文作者是BivásBiswas,他是可視化公司Zoic Labs的高級工程師,他在文章中提出了幾個觀點:

LiDAR開啟AR交互大門;

Reality Composer有望成為下一個iMovie;

AR中的錨點和真實物體相互依存。

1,為什么說LiDAR開啟AR交互體驗大門

蘋果已經在2020年為iOS設備引入LiDAR傳感器,雖然目前僅僅集中在Pro系列設備中,但是這依然讓我們看到了AR交互的潛力。

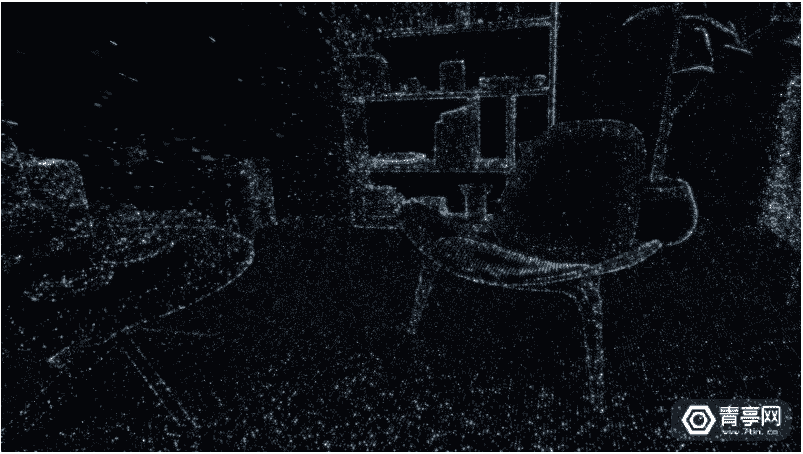

LiDAR自身優勢很廣泛,在iPhone、iPad這類小型化設備上,做到了5米測距,意味著以中心為直徑的10米的圓形內都可以被檢測到,這滿足了大多數室內場景。

BivásBiswas表示:LiDAR已經廣泛應用到機器人等領域,它可以讓機器人“了解”現實世界的環境,以及相對空間中的位置和方向等等。而你的手機可以看作是一個“沒有機器臂的機器人”,但是它有核心處理能力,內置了一些傳感器,而LiDAR就是最新型的傳感器之一。

我們知道。人類通過雙目視差的方式獲取深度信息。而基于計算機雙目視覺的、實時幀率計算方案成本則非常昂貴。LiDAR的出現,讓我們可以通過LiDAR+單目視覺實現這些功能。

和以往只能拍攝2D照片不同,結合LiDAR后可以識別深度信息,甚至完成3D掃描工作,這已經是移動設備上很大的進步。因此,基于LiDAR就可以實現更復雜、更全面的AR內容。

當然,這里就需要一套更人性化的框架,它需要降低操作復雜性,拋開底層技術原理,可以方便地讓開發者、設計師、藝術創作者等完成創作,降低開發難度和周期,提高開發效率。

2,Reality Composer有望成為下一個iMovie

iMovie是蘋果公司官方的視頻編輯應用,它的特點是可以更快、更輕松的完成視頻剪輯工作,同時支持iOS、macos等平臺。

回到iOS系統,它也應該擁有和iMovie相對應的AR編程框架,即ARKit、RealityKit。ARKit是整個AR平臺的底層基礎,用于處理IMU、LiDAR、視覺等數據信息,而RealityKit則是基于ARKit平臺的內容創作框架。

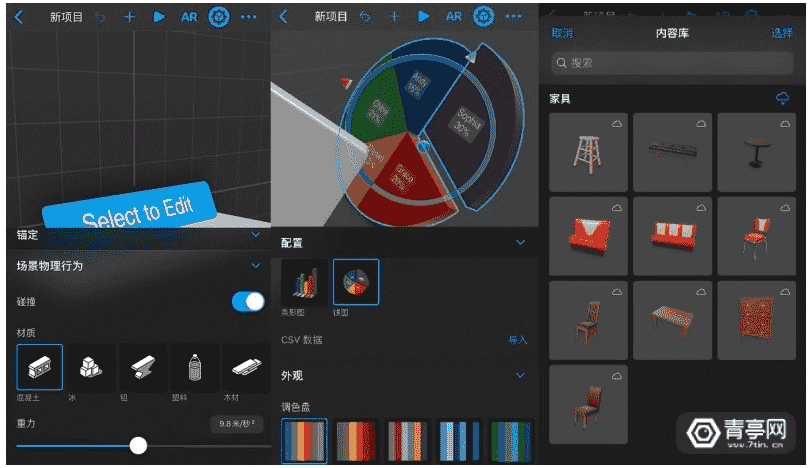

在RealityKit中(Reality Composer,伴隨iOS 13.1系統發布一同上線),你可以進行各種各樣的創作,它的特點就是讓你通過你通過拖拽、點擊等簡單的操作即可構建可互動的AR場景,同時內置大量3D內容數據庫,還可與Xcode和iOS應用配合使用,這樣就能實現AR場景快速預覽并進行微調,大幅提升效率。

Reality Composer不僅僅具備極佳的陰影、照明、環境反射效果,而且還深度打通USDZ,實現蘋果整套開發工作的閉環,無疑不是讓蘋果在AR創作中更輕松。

當然,很多人也知道例如Unreal虛幻引擎、Unity、3DSMax、Maya等工具也可以完成這些創作,而且可以導出為USDZ格式進行交互。而蘋果還在不遺余力地推動3D內容創作平臺Reality Composer等等工作,BivásBiswas推測這可能是為自家Mac生態系統提供端到端的AR內容創作方案。

談到Reality Composer的使用也非常輕松,它支持iOS和macOS雙平臺,在手機上你可以通過觸屏縮放,拖拽進行輕量化的AR內容創作,而在Mac上則可以完成更復雜的場景和交互。

而在Mac開發需要實時調試,尤其是對于AR開發工作而言,這就凸顯出了Reality Composer的重要性。因為基于強大的iCloud系統,可以讓USDZ文件快速的在iPhone進行預覽。

同時,蘋果還在Safari瀏覽器中提供AR快速預覽功能,只要是USDZ格式的文件,都可以在Safari瀏覽器進行快速預覽,這也是蘋果在AR生態構件中的重要一環。

3,AR中錨點和實物互相依存

我們知道,AR交互的重要工作是虛擬對象和真實世界像交互,而不是像谷歌眼鏡中那樣虛擬圖像會跟隨頭的方向轉來轉去,這其中的關鍵技術就是錨點固定。

也就是說,計算機生成的CG虛擬圖像,需要實時錨定在顯示物體之中,為此AR系統后臺不得不實時追蹤攝像頭數據,并且對每幀數據進行錨點更新。這其中涉及到ARFrame,它包含了攝像頭、錨點、場景、追蹤、映射狀態、地址位置等信息。

實際上,任何的虛擬物體(3D模型)都可以和錨點綁定,大到宇宙飛船,小到一個玻璃球。將虛擬物體錨定后,AR系統將對其進行深度追蹤,即便你繼續前后左右的移動,虛擬物體將保持固定在那里,就像是真實世界中的物體一般。

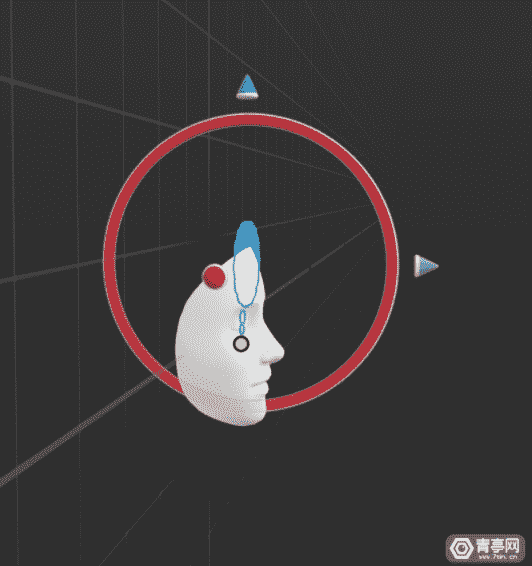

當ARKit檢測到人臉后,它會將錨點放置于鼻子后方(這是一個人眼不可見的區域),該錨點稱為ARFaceAnchor,也經常用于前置攝像頭用于人臉檢測。

ARFaceAnchor可以完成:眼睛追蹤、眼球追蹤、眉毛、頜骨等面部信息的追蹤,從而實現更好的面部AR交互效果,而這就是ARFaceGeometry屬性。

ARFaceGeometry的出現讓3D虛擬物體的面部互動成為可能,例如蘋果Animoji。而基于此,還可以完成AR美妝、甚至虛擬太陽鏡等等交互和玩法,和Snapchat的玩法差不多,只不過Snap應用了自己的開發平臺,而不是ARKit。

由此可知,在AR中實現追蹤并不是一件易事,一方面需要擁有更為強大的傳感器,另一方面還需要設備有足夠的算力。就現階段而言,移動AR體驗過程中,錨點不可避免地會有偏移,不僅僅是ARKit系統、就連HoloLens、Magic Leap也是如此,不同的設備偏移差也有所不同,但擁有完善的SLAM能力的AR頭顯效果相對更好一些。

無論如何,在移動設備上引入LiDAR是一個大的飛躍,它可以獲取環境3D信息,對虛擬對象實現更好的錨定和追蹤等。Reality Composer同樣具有極大潛力,綜合所有追蹤、錨點等技術,希望這些技術能夠成為開發出優質AR應用的好工具。

來源:青亭網