SIGGRAPH 2020大會即將召開,Facebook研究人員近日更新了一篇文章,介紹了“神經超采樣”(neural supersampling)技術。這是一種根據人工智能機器學習為基礎的提高圖像清晰度的算法技術,跟NVIDIA的DLSS“深度學習超采樣”技術相似。不同的是,這個神經超采樣并不需要專門的硬件或者軟件就能實現,基本可以媲美DLSS的效果。

這種“神經超采樣”算法可以獲得低分辨率的渲染幀并將其放大16倍,這意味著未來科技方向上將發生更多的變化。例如,未來的耳機,理論上可以驅動雙3K面板,每只眼睛只渲染1K——甚至不需要眼睛跟蹤。

能夠以較低的分辨率進行渲染,意味著更多的GPU功能可以自由運行詳細的著色器和高級效果,這可以彌合從移動虛擬現實到控制臺虛擬現實的差距。雖然這并不能把移動芯片變成游戲機,但它應該在某種程度上縮小差距。

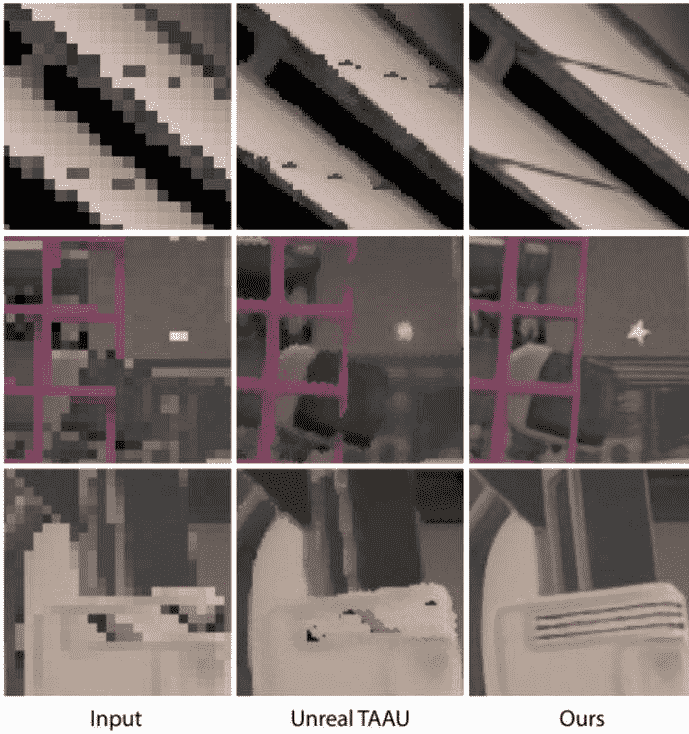

Facebook聲稱它的神經網絡是最先進的,它的性能超過了所有其他類似的算法——這也是它能夠實現16倍升級的原因。在所提供的示例圖像中,Facebook的算法似乎已經達到了可以重建線條或網格圖案等精細細節的地步。

事實上,早在3月份,Facebook就發表了一篇類似的文章。文中描述了利用神經上采樣來釋放GPU功耗的思想。研究人員的期望找出一個“框架”,在當前的渲染管道(低延遲)內實時運行機器學習算法,他們實現了這一點。將該框架與神經網絡相結合可以使這項技術實用化。

隨著AR/VR顯示器向著更高分辨率、更快的幀速率和更高的真實感的方向發展,神經超采樣方法可能是通過從場景數據中推斷出清晰細節而不是直接渲染這些細節的關鍵。這項工作為未來的高分辨率虛擬現實指明了方向,不僅僅是顯示器,還有實際驅動所需的算法。

目前,這只是一個研究,研究人員“相信通過進一步的網絡優化、硬件加速和專業級的工程設計,這種方法可以明顯更快”。Facebook將這種方法歸類為“神經渲染”,科技的更迭正以超出了任何人的預期的速度發展著。

文/陳根

來源:澎湃新聞·澎湃號·湃客